La conversión de decimal a notación científica simplifica cálculos complejos, optimizando la representación numérica para análisis avanzados en ingeniería exacta.

Descubra cómo convertir números decimales a notación científica utilizando fórmulas precisas, ejemplos realistas y herramientas de cálculo inteligente para profesionales.

Calculadora con inteligencia artificial (IA) – Conversión de decimal a notación científica

- Ejemplo: Convertir 0.00056 a notación científica.

- Ejemplo: Convertir 123456789 a notación científica.

- Ejemplo: Convertir -0.0034 a notación científica.

- Ejemplo: Convertir 9.81 a notación científica.

Fundamentos y relevancia de la conversión

La conversión de un número decimal a notación científica es una técnica esencial en ciencias, matemáticas e ingeniería. Esta representación permite expresar números muy grandes o muy pequeños de manera compacta, facilitando cálculos y comparaciones. El proceso optimiza análisis y reduce errores de redondeo en operaciones complejas.

En el ámbito científico, es frecuente encontrarse con números que varían en órdenes de magnitud extremos. Por ello, la notación científica se utiliza para uniformizar y simplificar datos. En este artículo se explican los fundamentos, fórmulas, ejemplos prácticos y aplicaciones reales de la conversión de decimal a notación científica.

Conceptos básicos de la notación científica

La notación científica expresa un número como el producto de dos factores: un coeficiente (también llamado mantisa) y una potencia de diez. Esto se muestra en la forma:

Número = a × 10b

Donde:

- a es el coeficiente o la mantisa, que debe ser un número mayor o igual a 1 y menor que 10.

- b es el exponente, que indica cuántas veces se multiplica el número 10 para obtener el valor original.

Mediante esta representación, los números extremadamente grandes o muy pequeños se vuelven manejables y se facilitan operaciones aritméticas, especialmente en contextos científicos y de ingeniería.

Proceso y fórmulas para la conversión

La conversión de un número decimal a notación científica implica determinar la magnitud (exponente) y la mantisa. El proceso se puede resumir en los siguientes pasos:

- Identificar el número decimal (N).

- Calcular el exponente (b) como el entero que representa el orden de magnitud.

- Determinar la mantisa (a) dividiendo N entre 10b.

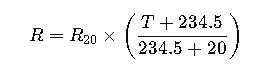

Fórmula para determinar el exponente

El exponente b se obtiene mediante la siguiente fórmula:

Donde:

- N es el número decimal a convertir.

- |N| es el valor absoluto del número N.

- log₁₀ es el logaritmo en base 10.

- entero() representa la función que toma la parte entera (o piso) del valor obtenido.

Fórmula para calcular la mantisa

Una vez calculado el exponente, la mantisa se determina con la siguiente fórmula:

Donde:

- a es la mantisa, que se ajusta para que 1 ≤ a < 10.

- N es el número decimal original.

- b es el exponente determinado previamente.

Si el número N es cero, se establece convencionalmente que la notación científica es 0 × 100 ya que log₁₀(0) es indefinido.

Pasos detallados en la conversión

Para convertir cualquier número decimal a notación científica, se recomienda seguir estos pasos:

- Determinar el valor absoluto: Evalúe |N| para trabajar con un número positivo.

- Calcular el exponente: Utilice la fórmula b = entero(log₁₀|N|) para obtener el orden de magnitud.

- Calcular la mantisa: Divida N entre 10b para ajustar el coeficiente a un número entre 1 y 10.

- Ajuste en caso de redondeo: Verifique que la mantisa no alcance el valor 10. Si es así, ajuste incrementando b en 1 y dividiendo la mantisa por 10 nuevamente.

Este procedimiento se aplica tanto a números positivos como negativos. Solo se debe conservar el signo en la mantisa.

Aplicaciones prácticas en el mundo real

La conversión de decimal a notación científica tiene múltiples aplicaciones en distintos campos. A continuación, se presentan dos casos de uso reales donde esta herramienta resulta indispensable.

Caso 1: Medición en astrofísica

En el campo de la astrofísica, es común trabajar con distancias y masas extremadamente grandes. Por ejemplo, la distancia entre la Tierra y una estrella lejana puede expresarse como 9.461 × 1012 kilómetros.

Problema: Suponga que se debe convertir la distancia 9461000000000 kilómetros a notación científica.

Solución:

- Paso 1: Identificar N = 9461000000000.

- Paso 2: Calcular el exponente:

b = entero(log₁₀(9461000000000)) ≈ entero(12.976) = 12. - Paso 3: Calcular la mantisa:

a = 9461000000000 / 1012= 9.461.

Por lo tanto, la distancia se expresa en notación científica como 9.461 × 1012 kilómetros. Esta representación permite a los astrofísicos trabajar con cifras uniformes y comprender mejor la escala del universo.

Caso 2: Análisis de mediciones en ingeniería eléctrica

En el diseño de circuitos electrónicos, se manejan valores de resistencia, capacitancia y otros parámetros que pueden cambiar en órdenes de magnitud. Por ejemplo, la capacitancia de un componente puede ser 0.00000000033 faradios.

Problema: Convertir 0.00000000033 faradios a notación científica.

Solución:

- Paso 1: Identificar N = 0.00000000033.

- Paso 2: Calcular el exponente:

b = entero(log₁₀(0.00000000033)) ≈ entero(-9.481) = -10. - Paso 3: Calcular la mantisa:

a = 0.00000000033 / 10-10= 3.3.

El resultado se expresa como 3.3 × 10-10 faradios. Utilizar la notación científica en este contexto permite a los ingenieros comparar componentes y analizar circuitos con mayor precisión, especialmente cuando se manejan escalas nanométricas.

Tabla comparativa de conversiones

| Número Decimal | Notación Científica | Descripción |

|---|---|---|

| 0.00056 | 5.6 × 10-4 | Número pequeño en medidas de laboratorio. |

| 123456789 | 1.23456789 × 108 | Cantidad en contabilidad o población. |

| -0.0034 | -3.4 × 10-3 | Valor negativo en mediciones de error. |

| 9.81 | 9.81 × 100 | Aceleración de la gravedad en m/s². |

| 9461000000000 | 9.461 × 1012 | Distancia astronómica medida en kilómetros. |

| 0.00000000033 | 3.3 × 10-10 | Capacitancia en circuitos electrónicos. |

Ventajas y desafíos en su aplicación

La adopción de la notación científica en la conversión de números decimales representa múltiples ventajas. Entre ellas destacan:

- Claridad: Reduce la complejidad de la notación, haciendo evidente el orden de magnitud.

- Eficiencia: Facilita cálculos, especialmente en el análisis de datos con rangos extremos.

- Uniformidad: Permite la comparación de resultados provenientes de diversas disciplinas.

- Optimización computacional: Mejora la precisión en cálculos de software científico y de ingeniería.

No obstante, se deben considerar ciertas limitaciones. La conversión podría ocasionar pequeños errores de redondeo si no se ajusta la mantisa de forma correcta. Asimismo, en contextos donde se requiera una precisión muy alta, se debe asegurar la configuración adecuada del formato numérico en las herramientas computacionales empleadas.

Herramientas y métodos computacionales

Con el auge de la tecnología, diversas aplicaciones y lenguajes de programación ofrecen funciones integradas para realizar esta conversión. A continuación, se describen algunos métodos populares:

- Python: Utilizando la función

format()o la funcióneen cadenas de formato, se puede expresar un número en notación científica. - MATLAB: Mediante la función

sprintf(), se puede convertir un número decimal a notación científica especificando el formato%e. - Excel: Permite la conversión automática mediante el formato de celdas personalizado, facilitando el manejo de datos en hojas de cálculo.

- C/C++: Las bibliotecas estándar incluyen formatos de salida que soportan notación científica al utilizar especificadores como

%eenprintf().

La elección de la herramienta dependerá del entorno de trabajo y de la precisión requerida en el análisis de datos. Es importante recordar que cada software puede tener ligeras diferencias en el manejo del redondeo y el formato final.

Casos prácticos avanzados y ejemplos adicionales

Para profundizar en el uso de la notación científica, se detallan dos ejemplos prácticos adicionales que abarcan desde la biología molecular hasta la economía aplicada.

Caso 3: Análisis de concentraciones en biotecnología

En biotecnología, se pueden medir concentraciones de sustancias a nivel molecular. Por ejemplo, la concentración de una hormona en sangre puede ser tan baja como 0.0000000025 moles por litro.

Problema: Convertir 0.0000000025 moles/l a notación científica.

Procedimiento:

- Identificación: N = 0.0000000025.

- Cálculo del exponente: Se obtiene b = entero(log₁₀(0.0000000025)) = entero(-8.602) = -9.

- Obtención de la mantisa: Se calcula a = 0.0000000025 / 10-9= 2.5.

El resultado es 2.5 × 10-9 moles/l, un formato que permite a los investigadores trabajar con valores extremadamente pequeños de forma clara y precisa.

Caso 4: Modelado financiero y análisis de inversiones

En el sector financiero, se pueden manejar cifras de inversión que alcanzan altos órdenes de magnitud. Por ejemplo, al analizar el valor de mercado de una gran corporación, se puede obtener un valor de 752000000000 dólares.

Problema: Convertir 752000000000 dólares a notación científica.

Solución:

- Identificación: N = 752000000000.

- Determinación del exponente: Se calcula b = entero(log₁₀(752000000000)) ≈ entero(11.876) = 11.

- Cálculo de la mantisa: Se obtiene a = 752000000000 / 1011= 7.52.

El valor se expresa como 7.52 × 1011 dólares. Este formato simplifica la interpretación de cifras financieras, facilitando el análisis comparativo, la presentación de reportes y la ejecución de cálculos complejos en modelos financieros.

Implicaciones en el análisis de datos y la comunicación científica

Adoptar la notación científica en la comunicación de resultados científicos y técnicos tiene importantes implicaciones. Entre ellas se destacan:

- Estandarización: Permite que investigadores de distintas áreas se comuniquen utilizando un sistema de representación numérica universal.

- Reducción de ambigüedades: Minimiza los errores de interpretación al trabajar con números con muchos dígitos.

- Facilidad de comparación: Los investigadores pueden comparar resultados de diferentes estudios sin verse afectados por diferencias en la escala de los datos.

- Claridad en la documentación: Los informes, artículos y presentaciones ganan en precisión y profesionalismo al utilizar un formato reconocido internacionalmente.

Además, la transformación de datos numéricos a notación científica contribuye a la optimización de algoritmos y procesos en el análisis computacional, sobre todo en áreas que requieren un manejo intensivo de números y operaciones aritméticas precisas.

Comparativa entre notación científica y otras representaciones numéricas

Es útil comparar la notación científica con otros formatos de representación numérica para entender sus ventajas. A continuación se presentan algunas diferencias clave:

- Números enteros: Su representación es directa, pero una vez que las cifras crecen en magnitud, se dificulta la legibilidad.

- Números en formato decimal: Aunque son comunes en informes, pueden complicar la interpretación de valores extremos.

- Notación científica: Reduce significativamente el número de cifras requeridas para expresar un valor, separando la magnitud (exponente) de la precisión (mantisa).

Por ejemplo, comparar 0.000000123 con 1.23 × 10-7 ilustra cómo la notación científica unifica la representación de valores muy pequeños, reduciendo la probabilidad de error al contar ceros o calcular manualmente los exponentes.

Implementación en software y scripts

La conversión de decimal a notación científica es un proceso automatizado en muchos entornos de programación y análisis de datos. A continuación, se muestra un ejemplo en pseudocódigo para ilustrar el algoritmo:

Función convertirANotacionCientifica(N):

Si N == 0:

retornar "0 × 10^0"

fin_si

b = entero(log10(|N|))

a = N / (10^b)

retornar a + " × 10^" + b

FinFunción

Este pseudocódigo puede adaptarse a diversos lenguajes de programación, demostrando que la lógica detrás de la conversión es sencilla y fácilmente implementable. La estructura modular del algoritmo permite su integración en sistemas de análisis numérico y aplicaciones científicas.

Aspectos pedagógicos y formativos

En la educación, comprender la notación científica es fundamental para estudiantes de secundaria, universitarios y profesionales técnicos. La conversión de decimal a notación científica:

- Ayuda a entender el concepto de orden de magnitud.

- Fomenta el dominio del uso de logaritmos y funciones exponenciales.

- Mejora la capacidad de trabajar con datos reales en investigaciones y experimentos.

El uso de ejemplos prácticos, como los expuestos en este artículo, favorece una mejor comprensión del proceso y resalta la aplicabilidad en contextos diversos, desde la física hasta la economía, pasando por la biotecnología.

Preguntas frecuentes (FAQ)

-

¿Por qué es importante la notación científica?

La notación científica permite representar números muy grandes o pequeños de forma compacta, optimizando cálculos y reduciendo errores en procesos científicos y técnicos.

-

¿Cómo se determina el exponente en la conversión?

El exponente se calcula usando la función logarítmica en base 10, redondeado a su parte entera, para identificar el orden de magnitud del número.

-

¿Qué ocurre si el número a convertir es cero?

Cuando el número es cero, se define convencionalmente la notación científica como 0 × 100 debido a la indeterminación del logaritmo de cero.

-

¿Se puede utilizar la notación científica en cálculos financieros?

Sí, en finanzas se utiliza para representar cifras de gran envergadura, facilitando la comparación y análisis de datos.

-

¿Qué herramientas permiten la conversión automática?

Lenguajes de programación como Python, MATLAB, y herramientas como Excel incluyen funciones para convertir números decimales a notación científica de forma automática.

Enlaces de referencia y recursos adicionales

Para ampliar sus conocimientos sobre la notación científica y su aplicación, puede consultar los siguientes recursos externos y artículos relacionados:

- Wikipedia – Notación Científica

- Khan Academy – Logaritmos

- Math is Fun – Scientific Notation

- Coursera – Cursos en Matemáticas y Ciencias

Perspectivas futuras y desarrollos innovadores

El manejo de datos numéricos continúa evolucionando, y la notación científica sigue siendo una herramienta clave en la simplificación de cálculos y en la estandarización de la información. Con el avance en inteligencia artificial y procesamiento de datos, se espera que nuevos algoritmos y herramientas automaticen la conversión y el análisis de números complejos.

Por ejemplo, los sistemas de cálculo simbólico y numérico basados en IA están integrando módulos que realizan conversiones en tiempo real, ofreciendo recomendaciones y validaciones automáticas basadas en grandes volúmenes de datos. Esto no solo mejora la eficiencia en el procesamiento, sino que también contribuye a la toma de decisiones en campos como la ingeniería aeroespacial, la economía y la medicina.

Consideraciones finales sobre la conversión

En síntesis, la conversión de decimal a notación científica es una práctica indispensable para la estandarización y el manejo preciso de datos en contextos multidisciplinarios. Su comprensión y correcta aplicación favorecen el análisis riguroso y la comunicación efectiva de resultados numéricos.

Utilizando las fórmulas expuestas, tablas comparativas y casos prácticos, cualquier profesional o estudiante puede abordar problemas complejos con mayor claridad y eficiencia. La integración de herramientas computacionales y recursos educativos potencia este conocimiento, convirtiéndolo en un elemento central en la formación técnica y científica.

Aspectos prácticos en el entorno laboral

En el ámbito profesional, la conversión a notación