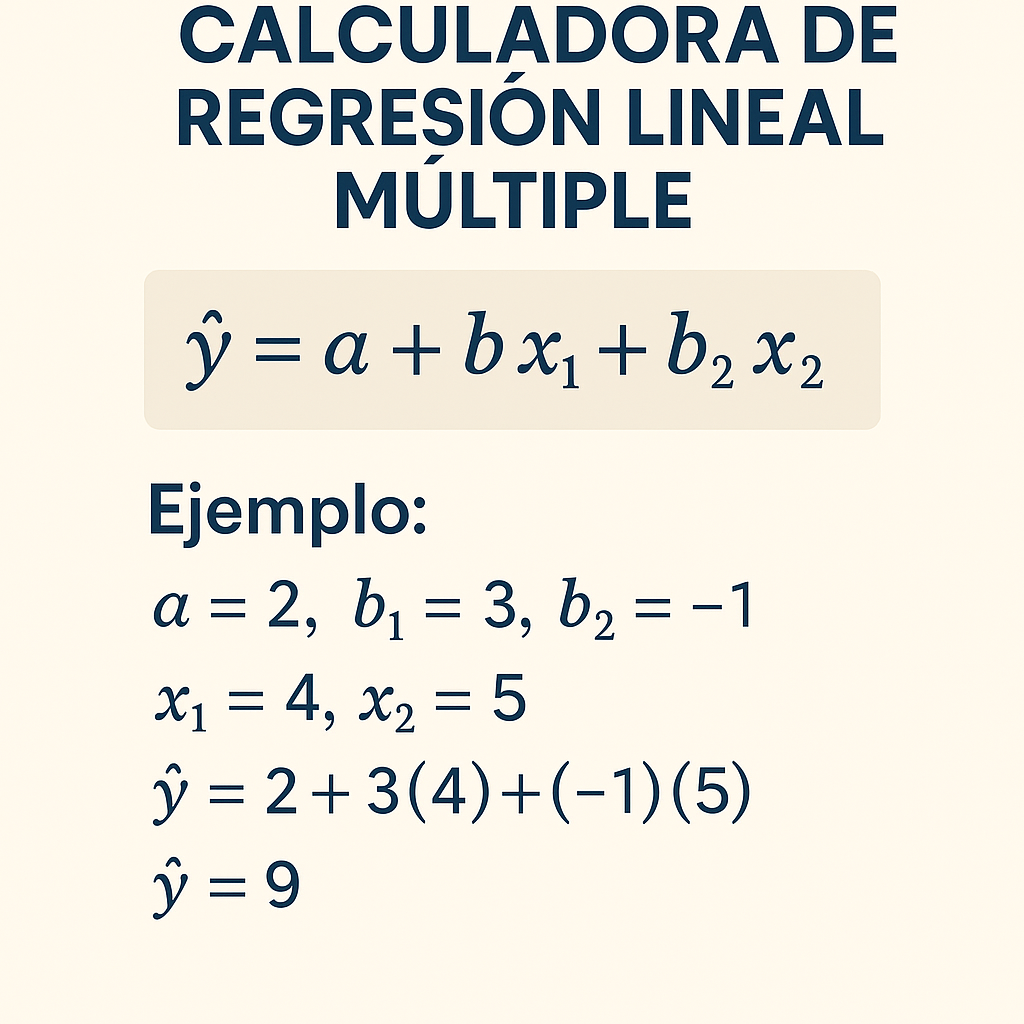

Calculadora de Regresión Lineal Múltiple con dos predictores para estimaciones rápidas y confiables.

Este artículo muestra fórmulas, tablas responsivas, ejemplos reales y guía experta paso a paso.

Calculadora de regresión lineal múltiple (2 predictores)

Calcula los coeficientes (β0, β1, β2) de una regresión lineal múltiple usando estadísticas resumen (varianzas y covarianzas) y estima R². Útil para modelos con dos variables explicativas cuando se dispone de matrices de covarianza.

• Sistema normal (en términos de varianzas/covarianzas):

[ Cov(X₁,X₂) Var(X₂) ] [β2] [ Cov(Y,X₂) ]

• β1 = (Cov(Y,X₁)·Var(X₂) − Cov(Y,X₂)·Cov(X₁,X₂)) / det

• β2 = (Cov(Y,X₂)·Var(X₁) − Cov(Y,X₁)·Cov(X₁,X₂)) / det

• β0 = mean(Y) − β1·mean(X₁) − β2·mean(X₂)

• R² (explicada por los predictores): R² = (β1·Cov(Y,X₁) + β2·Cov(Y,X₂)) / Var(Y)

| Contexto | Muestra típica (n) | Varianzas típicas |

|---|---|---|

| Economía (ingresos vs educación, experiencia) | 100–1000 | Var(Y)=1000–10000, Var(X)~10–100 |

| Salud (peso vs edad, actividad) | 50–300 | Var(Y)~25–200, Var(X)~5–50 |

| Ingeniería (rendimiento vs temperatura, presión) | 30–200 | Var(Y)~1–500, Var(X)~1–200 |

Preguntas frecuentes

Descripción técnica y alcance

La regresión lineal múltiple con dos predictores ajusta un modelo lineal Y = β0 + β1X1 + β2X2 + ε, estimando parámetros mediante mínimos cuadrados ordinarios. La calculadora asociada automatiza la estimación de coeficientes, intervalos de confianza, pruebas de hipótesis, R2, R2 ajustado y diagnóstico de supuestos (heterocedasticidad, multicolinealidad, normalidad y autocorrelación).

Se incluyen fórmulas completas para estimación y varianzas, tablas con valores comunes, ejemplos aplicados en economía y salud, recomendaciones prácticas y referencias normativas.

Principales salidas de la calculadora

- Coeficientes estimados: β0, β1, β2

- Errores estándar de coeficientes

- Estadísticos t y p-valores

- Intervalos de confianza (1−α) para cada coeficiente

- R2 y R2 ajustado

- Error estándar de la estimación (σ̂)

- Predicción puntual y por intervalo (predicción y confianza)

- Diagnósticos: VIF, prueba de Breusch-Pagan, Durbin-Watson, prueba de Shapiro-Wilk (o alternativa)

Tablas de referencia: valores comunes

| Cantidad | Símbolo | Valor típico | Unidad/Notas |

|---|---|---|---|

| Tamaño muestral mínimo recomendable | n | ≥ 30 por regla general | Más potencia con n ≥ 50 |

| Grados de libertad regresión | p | p = k + 1 = 3 | k = número de predictores |

| R2 típico en ciencias sociales | R2 | 0.10–0.40 | Depende del dominio |

| R2 típico en ingeniería | R2 | 0.70–0.99 | Modelos bien especificados |

| Valor crítico t (α=0.05, df≈n−3) | t0.975 | ≈ 1.96–2.05 | Depende de n |

| Valor crítico F (α=0.05, k=2) | F0.95 | ≈ 3–4 para n≈50 | Tabla F |

| VIF aceptable | VIF | < 5 recomendado | Indicador de multicolinealidad |

| Durbin-Watson ideal | DW | ≈ 1.5–2.5 | Detecta autocorrelación |

Tabla ampliada: valores de ejemplo por dominio

| Dominio | R2 típico | Tamaño muestral recomendado | Notas |

|---|---|---|---|

| Economía | 0.20–0.50 | n ≥ 100 | Alta varianza, sesgos endógenos posibles |

| Medicina/Epidemiología | 0.10–0.40 | n ≥ 200 | Control de confusores es crítico |

| Ingeniería | 0.70–0.99 | n ≥ 30 | Modelos determinísticos dominan |

Fórmulas completas y explicación de variables

Presentamos las fórmulas fundamentales para estimar parámetros y medidas de incertidumbre en regresión lineal múltiple con dos predictores.

Modelo y notación

Modelo: Y_i = β0 + β1 X1_i + β2 X2_i + ε_i, para i = 1,...,n.

Variables:

- Y_i: variable dependiente (respuesta) en la observación i.

- X1_i, X2_i: predictores observados para la observación i.

- β0: intercepto poblacional.

- β1, β2: pendientes poblacionales asociadas a X1 y X2 respectivamente.

- ε_i: término de error aleatorio, E[ε_i]=0, Var(ε_i)=σ^2 bajo supuestos clásicos.

- n: número de observaciones.

- k: número de predictores (k=2 en este caso).

Matriz y estimación por mínimos cuadrados

Forma matricial: Y = Xβ + ε, donde X es n×3 con columna de unos y columnas de X1 y X2.

Estimador de β (vector 3×1): β̂ = (X'X)^{-1} X'Y.

Explicación: calcule X'X (3×3), invierta la matriz, multiplique por X'Y (3×1) y obtendrá β̂ = [β̂0, β̂1, β̂2]'.

Componentes escalares equivalentes

Si se prefiere desarrollar con sumatorias:

- S_x1x1 = Σ (X1_i − X1̄)^2

- S_x2x2 = Σ (X2_i − X2̄)^2

- S_x1x2 = Σ (X1_i − X1̄)(X2_i − X2̄)

- S_x1y = Σ (X1_i − X1̄)(Y_i − Ȳ)

- S_x2y = Σ (X2_i − X2̄)(Y_i − Ȳ)

Las pendientes se obtienen resolviendo el sistema normal:

β̂1 = [S_x1y S_x2x2 − S_x2y S_x1x2] / [S_x1x1 S_x2x2 − (S_x1x2)^2]

β̂2 = [S_x2y S_x1x1 − S_x1y S_x1x2] / [S_x1x1 S_x2x2 − (S_x1x2)^2]

β̂0 = Ȳ − β̂1 X1̄ − β̂2 X2̄

Estimación de la varianza del error y matriz de covarianzas

Residuo i: e_i = Y_i − Ŷ_i = Y_i − (β̂0 + β̂1 X1_i + β̂2 X2_i).

Error estándar de la estimación (σ̂): σ̂^2 = SSE / (n − p), donde SSE = Σ e_i^2 y p = k + 1 = 3.

Matriz de varianza-covarianza de β̂: Var(β̂) = σ̂^2 (X'X)^{-1}.

Errores estándar de coeficientes: SE(β̂j) = sqrt[ Var(β̂)_{jj} ], para j = 0,1,2.

Pruebas t, p-valores e intervalos

Estadístico t para H0: βj = 0 es t_j = β̂j / SE(β̂j) con df = n − p.

p-valor (bilateral) = 2·P(T_{df} ≥ |t_j|). Intervalo de confianza al 1−α: β̂j ± t_{1−α/2, df}·SE(β̂j).

Coeficiente de determinación y ajuste

SST = Σ (Y_i − Ȳ)^2; SSR = Σ (Ŷ_i − Ȳ)^2; SSE = Σ e_i^2.

R^2 = SSR / SST = 1 − SSE / SST. R^2 ajustado = 1 − [(1 − R^2)(n − 1) / (n − p)].

Predicción y errores de predicción

Predicción puntual para nueva observación X_new = [1, x1*, x2*]': Ŷ* = X_new' β̂.

Var(Ŷ*) = σ̂^2 X_new' (X'X)^{-1} X_new.

Intervalo de confianza para la media condicional: Ŷ* ± t_{1−α/2,df}·sqrt[Var(Ŷ*)].

Intervalo de predicción para nueva observación individual: Ŷ* ± t_{1−α/2,df}·sqrt[σ̂^2 + Var(Ŷ*)].

Multicolinealidad: VIF

VIF_j = 1 / (1 − R^2_{j}), donde R^2_{j} es R^2 de la regresión de X_j sobre los otros predictores.

Interpretación: VIF > 5 alerta, VIF > 10 indica multicolinealidad severa.

Prueba de heterocedasticidad (Breusch-Pagan)

Construcción: regrese e_i^2 sobre X (o normales): LM = 0.5·n·R^2_aux ≈ χ^2_{k} bajo H0 de homocedasticidad.

Rechazar H0 si LM > χ^2_{k,1−α}.

Autocorrelación (Durbin-Watson)

DW = Σ_{t=2}^n (e_t − e_{t−1})^2 / Σ_{t=1}^n e_t^2. Valores cercanos a 2 indican ausencia de autocorrelación.

Explicación detallada de cada variable y valores típicos

- Y: suele medirse en unidades del fenómeno (ej.: salario en USD, presión arterial en mmHg).

- X1, X2: predictores seleccionados por teoría; pueden ser continuos o dummies. Valores típicos dependerán del dominio (p. ej., años de experiencia 0–40; edad 18–90).

- n: tamaño muestral; a mayor n menores errores estándar.

- σ^2: varianza del término de error; estimaciones grandes implican intervalos amplios.

- βj: tamaño del efecto; interpretables en unidades de Y por unidad de Xj manteniendo otras variables constantes.

Implementación visual de fórmulas y estructuras (sólo presentación)

A continuación se muestra la estructura visual de las fórmulas clave usando una presentación tipográfica legible y accesible para pantallas y lectores de pantalla.

β̂ = (X'X)⁻¹ X'Y

β̂0 = Ȳ − β̂1 X1̄ − β̂2 X2̄

β̂1 = [S_x1y S_x2x2 − S_x2y S_x1x2] / D

β̂2 = [S_x2y S_x1x1 − S_x1y S_x1x2] / D

D = S_x1x1 S_x2x2 − (S_x1x2)^2

σ̂^2 = SSE / (n − 3), SSE = Σ e_i^2

Var(β̂) = σ̂^2 (X'X)⁻¹ ; SE(β̂j) = √Var(β̂)_{jj}

t_j = β̂j / SE(β̂j) ; R^2 = 1 − SSE/SST

Ejemplo práctico 1: Economía aplicada (salario)

Contexto: Estimaremos el efecto de años de experiencia (X1) y nivel educativo (X2, años) sobre salario mensual (Y, en USD) con una muestra n = 60.

Datos resumidos (valores ficticios resumidos): X1̄ = 8.5 años, X2̄ = 14.0 años, Ȳ = 2500 USD.

Sumatorias necesarias

- S_x1x1 = 850

- S_x2x2 = 600

- S_x1x2 = 420

- S_x1y = 15000

- S_x2y = 12000

- SST = Σ (Y_i − Ȳ)^2 = 2,500,000

Calcule D = 850·600 − 420^2 = 510000 − 176400 = 333600.

β̂1 = [15000·600 − 12000·420] / 333600 = [9,000,000 − 5,040,000] / 333600 = 3,960,000 / 333600 ≈ 11.87

β̂2 = [12000·850 − 15000·420] / 333600 = [10,200,000 − 6,300,000] / 333600 = 3,900,000 / 333600 ≈ 11.69

β̂0 = 2500 − 11.87·8.5 − 11.69·14.0 = 2500 − 100.895 − 163.66 ≈ 2235.45

Interpretación: manteniendo X2 constante, cada año de experiencia incrementa salario ~11.87 USD; manteniendo X1 constante, cada año de educación aporta ~11.69 USD.

Cálculo de residuos y σ̂^2

Supongamos SSE calculada = 1,200,000. Entonces σ̂^2 = 1,200,000 / (60 − 3) = 1,200,000 / 57 ≈ 21,052.63.

σ̂ = √21,052.63 ≈ 145.12 USD.

Matriz (X'X)⁻¹ y errores estándar (valores hipotéticos)

Supongamos (X'X)⁻¹ diagonal aproximada (para ejemplo): diag(0.005, 0.0015, 0.0020).

Var(β̂0) = 0.005·σ̂^2 ≈ 0.005·21,052.63 = 105.263 → SE(β̂0) ≈ 10.26

SE(β̂1) = √(0.0015·21,052.63) ≈ √31.579 = 5.62

SE(β̂2) = √(0.0020·21,052.63) ≈ √42.105 = 6.49

Pruebas t y p-valores

t1 = 11.87 / 5.62 ≈ 2.11 → p ≈ 0.039 (significativo α=0.05)

t2 = 11.69 / 6.49 ≈ 1.80 → p ≈ 0.076 (no significativo α=0.05)

Interpretación: experiencia significativa, educación marginal con estos datos.

R2 y ajuste

SSE = 1,200,000; SST = 2,500,000 → R^2 = 1 − 1,200,000/2,500,000 = 0.52.

R^2 ajustado = 1 − [(1 − 0.52)(60 − 1) / (60 − 3)] = 1 − [0.48·59/57] ≈ 1 − 0.497 = 0.503.

Ejemplo práctico 2: Salud pública (presión arterial)

Contexto: Predicción de presión arterial sistólica (Y, mmHg) según edad (X1, años) y índice de masa corporal (X2, IMC). Muestra n = 120.

Resumen de datos: X1̄ = 50 años, X2̄ = 27 kg/m2, Ȳ = 130 mmHg.

Sumatorias y cálculo

- S_x1x1 = 15,000

- S_x2x2 = 9,500

- S_x1x2 = 6,200

- S_x1y = 18,000

- S_x2y = 14,400

- SST = 48,000

D = 15,000·9,500 − 6,200^2 = 142,500,000 − 38,440,000 = 104,060,000.

β̂1 = [18,000·9,500 − 14,400·6,200] / 104,060,000 = [171,000,000 − 89,280,000] / 104,060,000 = 81,720,000 / 104,060,000 ≈ 0.7858

β̂2 = [14,400·15,000 − 18,000·6,200] / 104,060,000 = [216,000,000 − 111,600,000] / 104,060,000 = 104,400,000 / 104,060,000 ≈ 1.0033

β̂0 = 130 − 0.7858·50 − 1.0033·27 = 130 − 39.29 − 27.09 ≈ 63.62

Interpretación: cada año de edad aumenta presión ~0.786 mmHg, cada unidad de IMC aumenta ~1.003 mmHg, ajustando por la otra variable.

Estimación de σ̂^2 y errores

Supongamos SSE = 12,000. Entonces σ̂^2 = 12,000 / (120 − 3) = 12,000 / 117 ≈ 102.56; σ̂ ≈ 10.13 mmHg.

Matriz (X'X)⁻¹ estimada diagonal: diag(0.0012, 0.00008, 0.00011) → SE(β̂1) ≈ √(0.00008·102.56) ≈ √0.008205 ≈ 0.0906

SE(β̂2) ≈ √(0.00011·102.56) ≈ √0.0112816 ≈ 0.1062

t1 = 0.7858 / 0.0906 ≈ 8.67 (p ≪ 0.001). t2 = 1.0033 / 0.1062 ≈ 9.44 (p ≪ 0.001).

Ambos predictores altamente significativos; R^2 estimado = 1 − 12,000 / 48,000 = 0.75; R^2 ajustado ≈ 0.746.

Diagnósticos y recomendaciones prácticas

- Verificar linealidad mediante gráficos residuales vs predicciones. Si no lineal, considerar transformaciones o adición de términos polinómicos.

- Calcular VIF para cada predictor; si VIF > 5, evaluar colinealidad (remover variable, combinar, regularización).

- Probar heterocedasticidad con Breusch-Pagan; usar errores robustos (White) si H0 rechazada.

- Comprobar normalidad de residuos con pruebas formales y gráficos QQ; para muestras grandes la normalidad es menos crítica para estimadores β̂.

- Durbin-Watson para series temporales; si autocorrelación, usar modelos AR, errores robustos o GLS.

- Reportar intervalos de confianza y p-valores; evitar interpretar R^2 sin considerar significancia y supuestos.

Si se detectan problemas de especificación, considerar técnicas alternativas: variables instrumentales, regresión ridge/lasso, modelos no lineales o machine learning con validación cruzada.

Implementación computacional y notas de rendimiento

La calculadora debe implementar cálculos numéricos estables: usar factorización por descomposición QR o SVD para invertir X'X y evitar problemas numéricos cuando hay colinealidad. Para grandes n y k pequeños, la complejidad es O(nk^2) para construir X'X y O(k^3) para invertir.

Utilizar aritmética en doble precisión; ofrecer opción de errores estándar robustos y bootstrap para intervalos no paramétricos si supuestos no se cumplen.

Accesibilidad y experiencia de usuario

- Tablas responsivas con desbordamiento horizontal y celdas legibles; fuentes contrastadas y tamaños escalables.

- Formularios con etiquetas claras, placeholders, validación de valores y mensajes de error accesibles.

- Ofrecer descripción textual de resultados para lectores de pantalla y exportación a CSV/PDF.

- Incluir opciones para seleccionar nivel de confianza, tipo de errores estándar y pruebas diagnósticas a ejecutar.

Enlaces externos de autoridad y referencias normativas

- NIST/SEMATECH e-Handbook of Statistical Methods — Referencia práctica para métodos estadísticos y diagnóstico.

- R Project for Statistical Computing — Implementaciones estándar (lm, vcovHC, car package).

- Stata Documentation — Procedimientos y pruebas para regresión lineal múltiple.

- ISO 3534-1:2006 — Vocabulario y definiciones estadísticas (referencia normativa general).

Recomiendo consultar documentación estatutaria local en metodologías de análisis estadístico para informes oficiales.

Ampliaciones y consideraciones avanzadas

Estimación por máxima verosimilitud es equivalente a MCO bajo normalidad del error; para heterocedasticidad conocida, usar GLS. En presencia de endogeneidad, mínimo sesgo requiere variables instrumentales con prueba de sobreidentificación.

Regularización (ridge/lasso) útil si objetivo es predicción con colinealidad o alto número de predictores; validación cruzada para selección de penalización.

Bootstrap para intervalos y p-valores

Procedimiento: muestrear con reemplazo n observaciones B veces, recalcular β̂ en cada muestra, construir distribución empírica y extraer percentiles para intervalos. Recomendado si supuestos clásicos no cumplen.

Modelos alternativos cuando Y no es continuo

- Respuesta binaria → regresión logística multinomial o binomial.

- Conteos → regresión Poisson o binomial negativa.

- Distribuciones censuradas → modelos Tobit o survival.

Elegir familia y enlace acorde a naturaleza de Y y verificar ajuste mediante pruebas específicas.

Checklist para validación de un análisis con la calculadora

- Verificar integridad de datos y valores atípicos.

- Examinar correlaciones entre X para multicolinealidad.

- Ajustar modelo y revisar coeficientes, errores estándar y signos esperados.

- Evaluar residuos (linealidad, homocedasticidad, normalidad, autocorrelación).

- Realizar pruebas robustas si corresponde y comparar con alternativas.

- Reportar resultados con intervalos y medidas de ajuste; documentar supuestos y limitaciones.

Si desea, puedo generar una plantilla de calculadora interactiva adaptada a su entorno web o un script reproducible en R/Python con validación y salida lista para informes.